Che cosa si intende con deepfake? Ne abbiamo parlato con l’artista del suono Halsey Burgund che ha diretto, assieme a Francesca Panetta, “In Event of Moon Disaster”: un progetto artistico / educativo realizzato dal MIT Center for Advanced Virtuality per aiutare le persone a comprendere meglio questo fenomeno (e la disinformazione).

E se vi dicessi che l’attore che interpreta Joker è Jim Carrey? No, sul serio, lo è! … Joaquin chi, dite? Vi sbagliate, mi spiace, sono abbastanza sicura che si tratti di Jim Carrey. Anzi, a pensarci, ho anche delle prove:

Visto?

Ma in effetti posso fornire prove di tante altre cose straordinarie: della partecipazione di Sylvester Stallone a Mamma ho perso l’aereo (qui), ad esempio, o del fatto che presto uscirà un remake di Ritorno al futuro che avrà per protagonisti Tom Holland e Robert Downey Jr. Ho anche le prime clip da mostrarti e le puoi trovare qui.

Adesso, prima che vi agitiate troppo: sì, lo confesso, stavo spudoratamente mentendo (anche se un po’ ci spero in quel remake). Quelli che vi ho mostrato sono degli esempi molto popolari di un fenomeno che prende il nome di deepfake e che è salito agli onori della cronaca (letteralmente, in effetti), negli ultimi due anni.

Avrete tutti visto video in cui Nicolas Cage compare anche se non avrebbe dovuto esserci (non sto parlando della sua intera filmografia, grazie tante).

Avrete visto video in cui Obama o Trump dicono cose che non hanno mai detto (mi spiace deludervi ma quello del disinfettante da iniettare per proteggersi dal Covid19 è tristemente vero).

Avrete anche sicuramente visto Jon Snow scusarmi per il finale dell’ottava stagione… e se non l’avete fatto, fatelo. Merita:

Questo falsi-video (e falsi audio) generati tramite intelligenza artificiale hanno preso le mosse in ambito accademico e di ricerca, ma l’origine scientifica ha presto lasciato spazio ad altri usi:

Ora è possibile creare falsi video utilizzando una tecnica di apprendimento automatico denominata “generative adversarial network”, o GAN. Uno studente laureato, Ian Goodfellow, ha inventato i GAN nel 2014 come un modo per generare algoritmicamente nuovi tipi di dati dai set di dati esistenti. […] L’uso di questa tecnica di apprendimento automatico è rimasto per lo più limitato alla comunità che si occupava di ricerca sull’intelligenza artificiale fino alla fine del 2017, quando un utente di Reddit che si faceva chiamare “Deepfakes” – un mix fra “deep learning” (apprendimento profondo) e “fake” (falso) – ha iniziato a postare video pornografici alterati digitalmente. Quello che stava facendo era costruire GAN usando TensorFlow, il software di apprendimento automatico open source e gratuito di Google, per sovrapporre i volti delle celebrità ai corpi di donne in film porno.

Oscar Schwartz, You thought fake news was bad? Deep fakes are where truth goes to die, in The Guardian, 12 Novembre 2018 [traduzione di fanheart3]

E se prima di leggere questa frase stavate tutti pensando alle possibilità per i fan (ad esempio, sovrapporre i volti di Dean Winchester e Castiel a quelli di Jack e Ennis all’interno di ogni scena di Brokeback Mountain – siamo fan innocenti, sappiamo dove si collocano le nostre priorità), ora la vostra mente ha probabilmente fatto un salto in avanti e intuito il vero problema che i deepfake nascondono.

Ovvero il fatto che, con il giusto apporto di conoscenza tecnologica e malvagità di cuore (termine tecnico) chiunque potrebbe prendere una qualsiasi notizia o situazione e far credere alla gente ciò che vuole di chi vuole.

Nulla di nuovo, qui. Abbiamo sentito talmente tanto parlare di “fake news”, recentemente, che ormai è un concetto che ci è diventato familiare.

Quello che personalmente conoscevo meno era l’idea di “apatia della realtà”, un pericoloso e inquietante effetto della situazione attuale:

[l’apatia della realtà viene a verificarsi quando] Assillate da un torrente di costante disinformazione, le persone, semplicemente, decidono di dare forfait e ignorare le notizie. Ovadya ci ricorda che questo è un comportamento comune nelle aree in cui le informazioni sono scarse e quindi ritenute errate. La grande differenza, osserva Ovadya, è l’adozione dell’apatia in una società sviluppata come la nostra. Il risultato, teme, non sarà buono. “Le persone smettono di prestare attenzione alle notizie e il livello fondamentale di informazione richiesto per una democrazia funzionale diventa instabile”

Charlie Warzel, He Predicted The 2016 Fake News Crisis. Now He’s Worried About An Information Apocalypse, in un articolo di Buzzfeed News article su Aviv Ovadya, fondatore del Thoughtful Technology Project [traduzione di fanheart3]

Ed in effetti, proprio l’altro giorno a fanheart3 stavamo discutendo delle varie reazioni al Covid19 fra le persone che conosciamo, e più di una di noi ha menzionato casi di parenti o amici lontani – e non così lontani – che ancora negano ciò che tutti sappiamo essere vero, nonostante il conteggio delle morti.

Ma se è vero che metà di noi (non una percentuale realistica, semplicemente un modo di dire) preferisce optare per l’approccio alla San Tommaso (“Se non vedo nelle sue mani il segno dei chiodi e non metto il dito nel posto dei chiodi e non metto la mia mano nel suo costato, non crederò”), l’altra metà non è nemmeno consapevole che manipolazioni come quelle offerte dai deepfake esistano e che l’abilità necessaria a crearle sia molto più diffusa di quanto si potrebbe credere.

Proprio per questo, quando abbiamo letto di In Event of Moon Disaster, installazione immersiva prodotta dal MIT Center for Advanced Virtuality e supportata da Mozilla e dal MIT Open Documentary Lab, abbiamo capito che dovevamo saperne qualcosa di più e comprendere meglio le ragioni per cui era stata creata.

Nel luglio del 1969, gran parte del mondo ha celebrato “un grande salto per l’umanità”. Cinquant’anni dopo, niente è così semplice. In Event of Moon Disaster illustra le possibilità offerte dalle tecnologie deepfake reinventando questo evento fondamentale. E se la missione Apollo 11 fosse andata male e gli astronauti non fossero stati in grado di rientrare a casa? Un discorso di emergenza per questa eventualità esisteva, ma non è stato mai pronunciato dal Presidente Nixon – fino ad ora.

Il progetto In Event of Moon Disaster nel loro sito ufficiale [traduzione di fanheart3]

Abbiamo dunque contattato Halsey Burgund, regista dell’esperienza assieme a Francesca Panetta. Elena ed io abbiamo avuto la possibilità di trascorrere un’ora su Zoom con lui, discutendo il tema delle fake news e della disinformazione, le tecnologie e l’audience e, ovviamente, l’incredibile lavoro che ha portato queste eccezionali persone a creare un’installazione che potrebbe davvero cambiare il modo di pensare di tanti. Un lavoro che può farci aprire gli occhi e scoprire quelli che sono i pericoli che abbiamo di fronte, ma anche le incredibili potenzialità che un uso etico di questi strumenti potrebbe aprire per il nostro futuro.

E per quello dei fan, in particolare.

Nota importante: questa intervista sarà pubblicata anche su XRMust – About Immersive Storytelling (link disponibile a breve)

In Event of Moon Disaster e deepfake: l’intervista a Halsey Burgund

Agnese: Ho visto il video che mi hai inviato (a / n quello di Nixon che legge il discorso) e sono rimasta sconvolta. Sapevo che era un video “falso” ma, lo ammetto, per un momento sono rimasta lì a guardare e dirmi, ok, mi sono persa qualcosa? È vero? Tra poco ti chiederò come avete creato il tutto, ma prima: qual è l’origine di questo progetto?

Circa un anno fa abbiamo avuto l’idea che sta alla base di “In Event of Moon Disaster”. Ci trovavamo in una stanza tutti assieme: io, Francesca (Panetta, co-regista del lavoro) e dei giornalisti che erano interessati alla tecnologia e ai vari modi in cui può essere utilizzata.

Stavamo facendo brainstorming su idee e possibilità diverse quando ci sono venuti in mente i deepfake. Era qualcosa di cui eravamo a conoscenza, e c’erano anche già preoccupazioni su di essi e in particolare sul fatto che non veniva fatto quasi nulla per controllarne l’uso. E poi è arrivato il 50° anniversario dell’atterraggio sulla luna – sono un grande fan dell’esplorazione dello spazio e di tutto ciò che rappresenta. Fu a quel punto che ricordammo il discorso di emergenza scritto per il presidente Nixon (da condividere con il Paese nel caso la missione fosse fallita e gli astronauti fossero morti sulla luna). Ed ecco l’illuminazione: facciamo in modo che il Presidente Nixon pronunci effettivamente questo discorso e costruiamo una storia alternativa per mostrare il potere che i deepfake hanno nell’ecosistema della disinformazione.

Il discorso di emergenza è bello, scritto meravigliosamente, e parla non solo dei singoli astronauti e del loro sacrificio, ma va oltre per toccare l’idea di esplorazione e di umanità… il fatto che non ci arrenderemo. Un messaggio di speranza che è risuonato dentro di noi in molti modi. Ovviamente se questo discorso fosse stato letto nella vita reale, avrebbe riguardato una grande tragedia, ma non è stato così. Sappiamo tutti che le cose non sono andate in quel modo. Mettere al centro quello specifico discorso non solo ribadisce che non è mai stato pronunciato, ma dà anche la possibilità di enfatizzare il nostro desiderio di esplorare, un desiderio che caratterizza l’umanità. Abbiamo pensato che poteva essere davvero un veicolo efficace per trasmettere i pericoli della disinformazione attraverso un’esperienza estetica ma anche una pedagogia più diretta.

Elena: la cosa che mi spaventa di più sono le notizie che non richiedono particolari tecnologie o conoscenze tecniche per essere falsificate. Per creare In Event of Moon Disaster servono determinate competenze, ma oggi chiunque può accedere a un sito Web e dire tutto ciò che desidera. Una cosa grandiosa per la libertà di parola, ma una cosa brutta per garantire l’accuratezza delle informazioni. Ad esempio, sappiamo tutti che i social media hanno algoritmi che tendono a convalidare le tue opinioni in modo che tu non riesca nemmeno a vederne di diverse. Molto è stato fatto a questo proposito, ma mi chiedo, qual è il futuro dell’informazione e della disinformazione secondo te?

E’ una domanda impegnativa. I social media sono basati sulla condivisione, ma ciò che di solito tendiamo a condividere è intrinsecamente più estremo. Inoltre, spesso condividiamo le cose troppo rapidamente, senza pensarci su. Forse, se avessimo il tempo di riflettere su quel post, tornarci su dopo un’ora dopo esserci calmati un po’, non lo condivideremmo o lo faremmo in modo diverso.

Non sono anti-social media anche se non li uso spesso: penso che possano portare grandi cose, ma possono essere anche molto dannosi. Tuttavia, le soluzioni non sono facili né ovvie e non posso fare finta di averle. Quello che stiamo facendo è solo cercare di sollevare un po’ il sipario su tutto questo per indurre le persone a pensarci su e a giudicare da sole.

Deepfakes e media sintetici possono essere usati sia per il bene che per il male. Ma la vera domanda con cui ti lasciano, alla fine dei conti, è la stessa: saremo mai più in grado di riconoscere la verità? Ci saranno sempre dei dubbi su ogni cosa che sentiamo o vediamo?

Sull’apatia della realtà

La cattiva informazione non è nuova. Non appena è arrivata l’informazione, non appena ci sono stati dei dati da riportare, c’è stato un modo per farli apparire diversi. Photoshop, per esempio, esiste da decenni e ti permette di usare foto reali manipolate per trasmettere qualcosa di non esistente. Tutti questi “cheap fakes” – riavvolgere i video, rallentare i video, tempismo sbagliato, ecc. – li abbiamo usati nel nostro filmato: abbiamo distorto le immagini di archivio creando qualcosa che presenta grandi inesattezze appositamente. Questo per mostrare che il nostro progetto non riguarda solo i deepfake, ma coinvolge anche i modi più facili per diffondere la cattiva informazione, modi che non richiedono una grande tecnologia. Se rallenti un video di Nancy Pelosi la fai apparire ubriaca e di conseguenza una persona che non è affidabile. Vogliamo mettere in luce questo fenomeno e le sue implicazioni e quindi abbiamo messo insieme un team di menti differenti – ricercatori mediatici, storici, giornalisti, esperti tecnici, ecc. – per affrontare tutto questo da differenti punti di vita, da una prospettiva sociale, filosofica, tecnologica, e così via.

Deepfakes e media sintetici possono essere usati sia per il bene che per il male. Ma la vera domanda con cui ti lasciano, alla fine dei conti, è la stessa: saremo mai più in grado di riconoscere la verità? Ci saranno sempre dei dubbi su ogni cosa che sentiamo o vediamo? Le persone semplicemente rinunceranno a tutto questo per diventare apatiche e non credere a nulla se non a quanto hanno potuto sperimentare di persona?

Devo ammettere che c’è una dissonanza tra Francesca e me: volevamo fare questo progetto al meglio delle nostre possibilità, ma nel fare ciò abbiamo contemporaneamente aumentato la nostra ansia e paura riguardo al futuro. E’ una delle molte sfide che ognuno affronta quando crea qualcosa di nuovo.

Agnese: cosa ci puoi dire della creazione di In Event of Moon Disaster? È stato difficile da realizzare? Quanto tempo ha impiegato il tuo team per completare il tutto?

La creazione di In Event of Moon Disaster ha richiesto un notevole sforzo. Certo, il deepfake è la parte preponderante, ma non tutto. Il resto del film ha richiesto molto tempo per l’editing e, come sempre, non avevamo tutti i fondi che avremmo voluto. Per quanto riguarda il deepfake, ci sono voluti circa quattro mesi per completarlo.

Abbiamo lavorato con due ditte: Canny AI per gli elementi visivi e Respeecher per i dialoghi sintetici. Volevamo davvero fare il lavoro migliore possibile con la tecnologia disponibile, perché sentivamo che parte del progetto consisteva nel dare una dimostrazione della tecnologia migliore che era disponibile al tempo. Dico “al tempo” perché le cose sono migliorate da allora. E, certo, abbiamo capito che lo sforzo che ci è voluto per creare qualcosa di quella qualità – indipendentemente dal fatto che pensiate che sia una qualità alta o bassa – sarà ridotto su base mensile. Mentre andiamo avanti, nuove tecnologie saranno disponibili e renderanno la produzione di lavori come questi sempre più facile per grandi gruppi di persone. La democratizzazione della tecnologia ad alto livello è una cosa buona ma se si parla di tecnologie come queste, si apre la strada a più ampie intenzioni manipolatrici.

Un aneddoto dalla nostra esperienza: quando abbiamo iniziato a lavorare con Canny AI sugli elementi visivi ci hanno dato istruzioni esplicite su cosa avevano bisogno da noi e e ci hanno detto che il target video (il video di Nixon che volevamo manipolare) doveva avere alcune caratteristiche. Praticamente doveva essere una ripresa ferma di Nixon che parla. Niente primi piani, niente movimento. Questo per rendere il risultato più convincente. Quindi abbiamo trovato un video diverso da quello che avevamo originariamente pensato di usare, dove la scena è iniziata con lui alla scrivania e poi si zoommava sulla sua faccia.

Ma poi, un mese più tardi, la ditta ha provato ad applicare delle modifiche al video che avevamo intenzione di usare all’inizio… e ha funzionato alla perfezione! Questo ha reso possibile l’aggiunta di altri elementi dinamici al discorso stesso e quindi l’ha reso più credibile.

In altre parole, solamente in campo a un mese o due, quella tecnologia che Canny AI ha sviluppato è migliorata significativamente. E, da allora, la tecnologia ha continuato a diventare sempre più di qualità e più facile da usare! Sono convinto che se dovessimo fare In Event of Moon Disaster oggi avremmo avuto risultati non solo più velocemente, ma anche molto più convincenti.

L’unica cosa che non cambierebbe è il fatto che la fonte che abbiamo ha 50 anni e questo crea molte sfide. Prendi ad esempio l’audio del presidente Nixon: ci sono varie registrazioni di lui, ma tutte in situazioni diverse, con microfoni e settings differenti, e questo è molto problematico e pone una grande sfida. Sono stati fatti molti passi in avanti nella riduzione del rumore e nell’analisi della frequenza, ma credo che la tecnologia non sia migliorata tanto quanto quella della produzione dei deepfake.

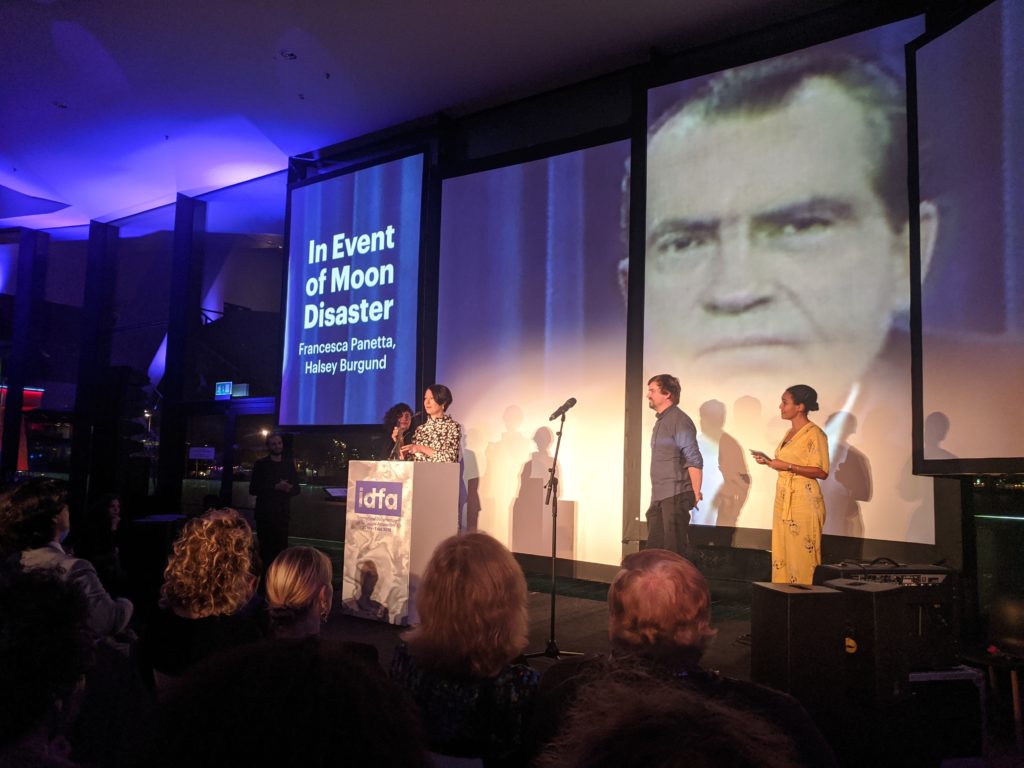

Agnese: penso che molte persone non siano nemmeno consapevoli che qualcosa del genere può essere creato e soprattutto che possa apparire così credibile. So che hai presentato In Event of Moon Disaster all’IDFA, the International Documentary FilmFestival Amsterdam. Sono curiosa: quali reazioni del pubblico hai notato? Erano sorpresi da ciò che stavano vivendo?

Noi siamo rimasti sorpresi da come ha reagito il nostro pubblico all’IDFA. Come artisti, volevamo davvero incapsulare la nostra installazione in un modo che sembrasse immersivo e non volavamo imporre l’educazione alle persone. Volevamo che avessero un’esperienza: entrano in questa stanza, si siedono nel divano, trovano volantini con pubblicità intelligenti riguardati i deepfake: “Sei stanco che la storia ti dica cos’è successo? Prova Deepfake!”… Il tutto per convogliare l’idea che quello che stavi sperimentando era realistico ma non veramente reale. E, nonostante questo, molti sono rimasti confusi dal video e dall’intera esperienza. Il fatto che fosse un deepfake non era chiaro a tutti. Alcuni pensavano che il video di Nixon fosse vero ma che non fosse stato mai messo in onda, altri pensavano che avessimo scritto noi il discorso (e ci hanno perfino fatto le congratulazioni!), altri non sapevano neanche chi fosse il Presidente Nixon. Tutte cose che non avevamo considerato e che abbiamo cercato di spiegare al nostro pubblico dopo l’esperienza stessa. Molte di queste persone alla fine hanno ricevuto il messaggio dopo che abbiamo parlato con loro, ma quanti invece se ne sono andati senza parlare con noi e quindi senza capire quello che cercavamo di comunicare? Una grande lezione per noi, per le nostre presentazioni future.

Il nostro progetto doveva essere al Tribeca Film Festival nelle scorse settimane settimana e stavamo proprio pensando a come gestirlo.

Siamo ancora dell’idea di incapsulare l’esperienza estetica e poi aprire un po’ il sipario, in particolare attraverso il website che stiamo ultimando e dire “Ok, questo non era reale, nonostante quello che avete sentito emotivamente quando lo avete sperimentato. L’abbiamo fatto così. Questo è il deepfake.” Speriamo di avere l’opportunità di fare esattamente questo nelle installazioni future.

Questa è un’informazione importante su cui dobbiamo discutere, ma parlarne nel contesto di una vera e propria opera d’arte – che è anche immersiva – potrebbe avere un impatto molto più significativo di quanto ne avrebbe il semplice parlarne in modo astratto.

Sull’importanza educativa di In Event of Moon Disaster

Elena: prima hai fatto riferimento al valore educativo di In Event of Moon Disaster. Volete portare questo lavoro anche nelle scuole?

Abbiamo portato nel team un produttore educativo, Joshua Glick, che sta lavorando su un curriculum per studenti del college sull’alfabetizzazione mediatica dove questa installazione sarà l’infrastruttura attorno alla quale l’alfabetizzazione mediatica verrà insegnata. Stiamo lavorando attivamente su questo perché pensiamo che ci sia molto da fare e guadagnare nel portarlo in un setting accademico rigoroso.

E’ materiale importante su cui discutere, ma parlarne nel contesto di una vera e propria opera d’arte – che è anche immersiva – potrebbe avere un impatto molto più significativo di quanto ne avrebbe il semplice parlarne in modo astratto. Per questo motivo vogliamo lavorare così a questo film e sempre per questo il Scientific American sta producendo un corto documentario su tutto ciò. E’ un documentario che riguarda i deepfake e come crearli, ma viene fatto nel contesto del nostro progetto: come l’abbiamo fatto, le sfide che abbiamo affrontato, ecc. Qualcosa che, speriamo, possa rendere In Event of Moon Disaster ancora più di impatto.

In Event of Moon Disaster è una produzione del MIT Center for Advanced Virtuality diretta da Francesca Panetta e Halsey Burgund e la sua creazione è stata supportata da Mozilla e dal MIT Open Documentary Lab.

Ringraziamo Halsey per il tempo dedicato a spiegarci il suo lavoro e per la passione che ci ha trasmesso durante l’intera conversazione! Vogliamo anche ringraziare tutto il team che ha collaborato alla creazione di qualcosa che non solamente ci ha entusiasmato ma che ci ha aperto ad un mondo che, per la maggior parte, ci era ancora sconosciuto.

Visitate il sito di In Event of Moon Disaster per conoscere meglio il fenomeno dei deepfake e seguire i prossimi passi di questo importante progetto educativo! E ricordatevi di prestate attenzione a quello che leggete online: se trovate scritto che sto uscendo con Russell Crowe, c’è un 90% di possibilità che si tratti di una bufala e l’80% di possibilità che sia stata io a diffonderla. Certo, qui contiamo ancora su quel 10%…

(intervista di Agnese e Elena)

1 commento

The Zizi Show: rieducare i deepfake e l’intelligenza artificiale - fanheart3 · 13 Marzo 2024 alle 11:04

[…] for Advanced Virtuality che ci aveva colpito parecchio: trattasi di In event of moon disaster, di cui avevamo intervistato uno dei creatori, Halsey Burgund, che aveva discusso con noi di deepfake, fake news e dei rischi (ma anche delle opportunità) […]

I commenti sono chiusi.